扩展功能

文章信息

- 徐慧智, 邢照昊.

- XU Huizhi, XING Zhaohao

- 基于递归全对场变换模型图像处理的驾驶人行为识别

- Driver behavior recognition based on image processed with recurrent all-pairs field transforms model

- 公路交通科技, 2025, 42(6): 50-57

- Journal of Highway and Transportation Research and Denelopment, 2025, 42(6): 50-57

- 10.3969/j.issn.1002-0268.2025.06.005

-

文章历史

- 收稿日期: 2023-11-29

据公安部统计,2023年中国机动车保有量达4.35亿辆,驾驶人数量达5.23亿人。驾驶人作为驾驶主体,对驾驶安全有重要影响。道路交通事故的各项成因中,驾驶人注意力不集中占比40%[1]。因此,判断驾驶人驾驶状态是否正常,是交通安全领域的研究方向之一。

目前,驾驶人行为识别研究可分为基于外部传感器的间接识别方法和基于计算机视觉的直接识别方法。外部传感器收集驾驶人操作数据(加速踏板压力、车速等)和驾驶人生理数据(脑电波、肌电等)[2]。Mohammad[3]利用加速度、重力、油门、速度和发动机转速等驾驶信号,识别了正常、激进、分心、昏昏欲睡和酒后驾驶5种驾驶风格。Fu[4]提出基于隐马尔可夫的驾驶人状态检测模型,通过输入驾驶人的脑电、肌电和呼吸信号,估计驾驶人的驾驶状态。Li[5]使用小波变换理论对驾驶人脑电信号进行降噪,并作为贝叶斯理论模型的输入,识别驾驶人行为和意图,最大识别率达到82.6%。申天啸[6]构建驾驶人眼动视频数据集VIPDAR _ 5,模拟视觉机制,训练TWNet模型,提高了驾驶人行为识别性能。王冠[7]通过Hough算法计算车道偏移率,并结合驾驶人头部姿态,分析是否出现分心驾驶。基于传感器的识别方法需要收集驾驶人状态信息,对系统硬件有特定要求,在实时场景中泛化能力不足,财务成本较高,难以应用于实际交通系统中[8]。在基于深度学习的视觉识别领域,Xiao[9]提出基于注意力的深度神经网络(ADNet),将空间注意力模块与通道注意力模块相结合,用于自适应特征提取,ADNet网络在AUC分心数据集进行训练及测试,准确率为98.48%。Zhao[10]提出基于自适应空间注意力机制的驾驶人行为检测系统,通过级联多个基于注意力机制的卷积神经网络,实现驾驶人图像中自适应判别空间区域提取。Jia[11]为了提高驾驶行为识别的准确性和鲁棒性,提出了基于软阈值和时间卷积网络的驾驶行为识别算法,并在公共数据集上进行了评估。杜虓龙[12]使用深度可分离卷积替换SSD网络中的特征提取网络,减少模型参数,在浅层中加入HDC处理模块,改进后的网络可以实时、准确地识别7种分心行为,mAP达到94.01%。Qin[13]使用轻量化D-DCNN模型在AUC和State Farm数据集上进行试验检测,准确度分别为95.59%和99.87%。驾驶室内图像背景复杂,研究者大多采用驾驶人行为简单的公开数据集,如State Farm数据集和AUC数据集,导致深度学习网络特征提取困难。Eraqi[14]使用CNN提取驾驶人行为图像特征,输入随机决策树进行分类。为追求更高的准确率,往往使用更深更复杂的网络结构,忽视模型文件大小和识别速度。

本研究构建了更有针对性的驾驶人行为数据集Driver-seq,用于训练MobileNet-GX深度学习神经网络。由于驾驶室环境复杂多变,影响神经网络的识别性能,据此提出了RAFT光流融合的图像预处理方法,利用光流对像素变换的敏感性,捕捉驾驶人行为。结合权重和亮度系数,对图像数据进行RAFT光流融合,消除驾驶室背景噪音影响,突出驾驶人行为。考虑到模型的可嵌入性和应用性,在轻量化网络MobileNet-V2的基础上,提出含有残差和全局平均池化层的GX模块替换全连接层。残差结构学习能力强,全局平均池化层可以抑制过拟合发生,MobileNet-GX具有良好的精确度和泛化能力。

1 数据获取及预处理 1.1 Driver-seq数据集在白天光照充足条件下,以家用轿车为试验背景,获取驾驶人直行、左转、右转、换挡、调节雨刷器、打电话、操作导航、喝水、吸烟等10类行为的图像数据,见表 1。

| 序号 | 正常驾驶人行为 | 序号 | 不良驾驶人行为 | |

| 1 | 直行 | 6 | 喝水 | |

| 2 | 左转 | 7 | 吸烟 | |

| 3 | 右转 | 8 | 打电话 | |

| 4 | 换挡 | 9 | 向后看 | |

| 5 | 调节雨刷器 | 10 | 操作导航 |

视频检测器安装在副驾驶A柱处,图像采样率为30帧/s,分辨率为1 920×1 080,共采集40 570张图像。筛选后,对8 069张图像进行数据集划分,训练集和测试比例为9∶1。各类驾驶人行为采集数量见表 2。同时,保持驾驶类型比例不变,将数据集增删至7 069,7 569,8 569,9 069张,研究数据集数量不同对神经网络精度的影响。

| 序号 | 驾驶类型 | 训练集 | 测试集 | 图像总数量 |

| 1 | 直行 | 844 | 93 | 937 |

| 2 | 左转 | 1 134 | 125 | 1 259 |

| 3 | 右转 | 841 | 93 | 934 |

| 4 | 换挡 | 1 026 | 114 | 1 140 |

| 5 | 喝水 | 451 | 50 | 501 |

| 6 | 吸烟 | 380 | 42 | 422 |

| 7 | 打电话 | 254 | 28 | 282 |

| 8 | 向后看 | 867 | 96 | 963 |

| 9 | 操作导航 | 1 010 | 112 | 1 122 |

| 10 | 调节雨刷器 | 459 | 50 | 509 |

| 总数 | — | 7 266 | 803 | 8 069 |

1.2 数据预处理 1.2.1 RAFT模型原理

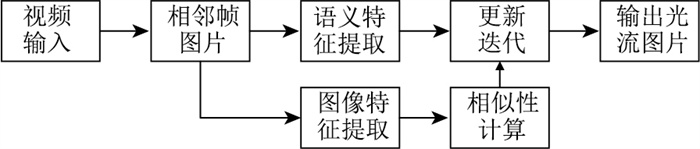

RAFT是基于深度学习的光流估计算法,通过迭代更新的方式逐步提取光流,速度快且精度高[15]。RAFT算法主要由3个部分组成,算法流程见图 1。

|

| 图 1 RAFT算法流程 Fig. 1 RAFT algorithm flow |

| |

(1) 特征提取模块

特征提取模块包括图像特征提取器和语义特征提取器,图像特征提取器提取第1帧和第2帧图像信息,映射通道数为256, 分辨率为1/8的密集特征。设特征提取器为g,映射关系见式(1)。

| $ g: R^{H \times W \times 3} \rightarrow R^{H / 8 \times W / 8 \times 256}, $ | (1) |

式中, R为空间, 语义特征提取器仅提取第1帧图像语义。

(2) 相似性计算模块

建模图像上任意两点之间的相似度。g (I1)、g (I2)分别表示第1帧图像I1和第2帧图像I2的特征,特征向量进行点积运算得相关量,见式(2)~(3)。

| $ \boldsymbol{C}\left(g\left(I_1\right), g\left(I_2\right)\right) \in \boldsymbol{R}^{H \times W \times H \times W}, $ | (2) |

| $ \boldsymbol{C}_{i j k l}=\sum\nolimits_h g\left(I_1\right)_{i j h} \cdot g\left(I_2\right)_{k l h}, $ | (3) |

式中,C为两幅图像特征向量点积计算得到的相似度; i, j, k, l分别为I1与I2特征的高、宽索引;h为图像特征的通道维度索引。

(3) 更新迭代模块

将光流状态、相关量和上一级单元输出的隐藏状态作为本级单元的输入(初始光流状态f0=0,初始隐藏状态为语义特征提取所得结果),输出光流更新量Δf和当前隐藏状态。更新后的光流状态见式(4)。

| $ f_{k+1}=\Delta f+f_{k+1} $ | (4) |

式中fk+1为第k+1个光流场状态。

1.2.2 图像融合技术图像融合是将两张或两张以上图像的信息融合为一张图像。图像融合技术可以提取自然条件下驾驶人动作图像和驾驶人光流图像的互补信息,得到准确表达的驾驶室图像。使用OpenCV中的addWeighted()函数对图像进行融合,淡化驾驶室干扰信息,在图像中突出表达驾驶人动作。对P1和P2两张图像进行融合,设融合权重分别为α和β,亮度调节参数为G,图像融合运算见式(5)。

| $ P_{\text {sum }}=P_1 \times \alpha+P_2 \times \beta+G_{\circ} $ | (5) |

VGG-16采用3×3的小卷积核,拥有更深的卷积网络结构,识别准确率高但耗费更多计算资源和储存资源。GoogLeNet[16]采用稀疏网络结构Inception,通过堆叠卷积和池化操作扩展网络宽度,具有更高的计算性能,但模型文件较大。ShuffleNet-V2[17]采用通道混洗,解决特征图不同通道间的通信问题。DenseNet[18]采用稠密卷积网络框架,加强了特征的重复利用,参数更少,易于训练。MobileNet-V2[19]保留了MobileNet-V1中的深度可分离卷积,使用深度卷积和逐点卷积代替常见的2D卷积,使模型趋于轻量化,可应用于嵌入式设备。MobileNet-V2改进了MobileNet-V1的直筒结构,受ResNet中的残差结构启发,提出倒残差结构,配合逐点卷积来复用图像特征数据,减少模型推理时间,提高模型性价比。本研究将优化后的MobileNet-V2网络作为驾驶人行为识别模型的骨干网络,采用迁移学习方法进行训练。

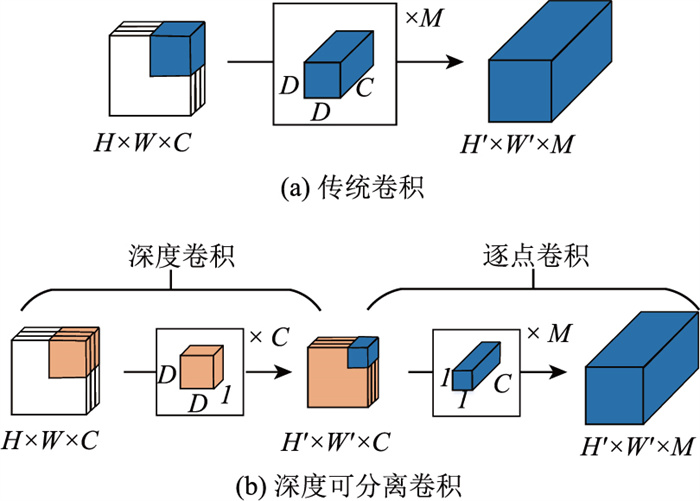

2.2 MobileNet-V2 2.2.1 深度可分离卷积深度可分离卷积包括深度卷积和逐点卷积,其与传统卷积对比见图 2。

|

| 图 2 传统卷积与深度可分离卷积对比 Fig. 2 Traditional convolution v.s. depthwise separable convolution |

| |

输入特征图尺寸为H×W×C (H,W为特征图长和宽,C为特征图通道数),最终输出特征图尺寸为H′×W′×M。在传统卷积中,卷积核与输入特征图的通道数相同,卷积核个数与输出特征图通道数相同,图中使用M个D×D×C的卷积核,改变输入特征图的大小和通道数。在深度卷积中,对输入特征图的每个通道分别使用1个卷积核进行卷积运算,输出的特征图不改变通道数,图中使用C个D×D×1卷积核,得到H′×W′×C的特征图。逐点卷积是特殊的传统卷积,卷积核的长和宽都为1,其卷积运算与传统卷积相同,扩宽特征图的深度,图中使用M个1×1×C的卷积核,最终得到H′×W′×M的目标特征图。

深度可分离卷积使用更少的参数和更快的推导速度,达到与传统卷积相同的输出效果。深度可分离卷积与传统卷积的参数量比值见式(6)。

| $ \frac{D \times D \times H \times W \times C+H \times W \times M \times C}{D \times D \times H \times W \times C \times M}=\frac{1}{M}+\frac{1}{D^2} \circ $ | (6) |

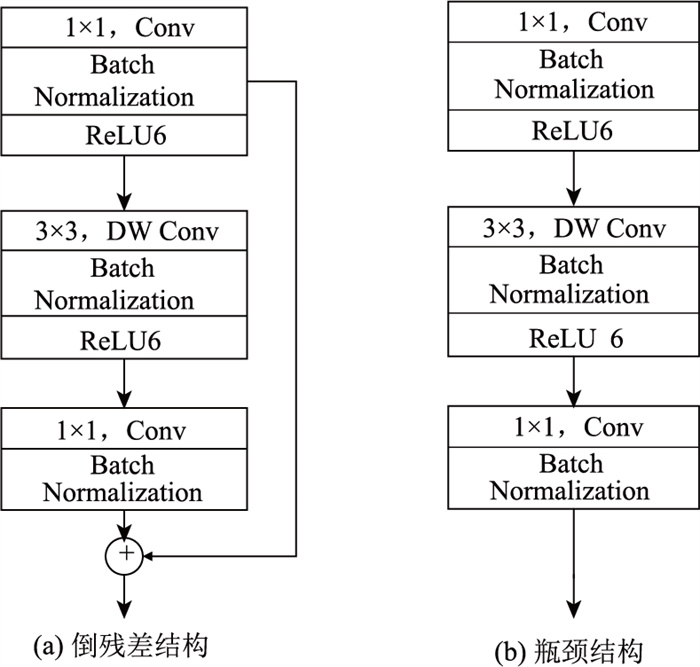

倒残差结构(Inverted Residual Block)与ResNet中的残差结构相反,先使用1×1的卷积将特征图升维,再通过深度卷积进行特征提取,最后使用1×1的卷积降维,呈现出带有残差的瓶颈结构(Bottleneck),见图 3。其意义是深度卷积可以在维度更高的特征图中提取更多信息。

|

| 图 3 瓶颈结构与倒残差结构对比 Fig. 3 Bottleneck structure v.s. inverted residual structure |

| |

当深度卷积的步幅(stride)为1,且输入特征矩阵与输出特征矩阵的宽、高、通道数相同时,采用倒残差结构,否则使用无捷径分支的瓶颈结构。MobileNet-V2模型结构见表 3。

| 输入 | 基本结构 | 步幅(stride) | |

| 2242×3 | Conv 3×3 | 2 | |

| 1122×32 | Bottleneck | 1 | |

| 1122×16 | Bottleneck | 2 | |

| Inverted residual block | 1 | ||

| 562×24 | Bottleneck | 2 | |

| Inverted residual block ×2 | 1 | ||

| 282×32 | Bottleneck | 2 | |

| Inverted residual block ×3 | 1 | ||

| 142×64 | Bottleneck | 1 | |

| Inverted residual block ×2 | 1 | ||

| 142×96 | Bottleneck | 2 | |

| Inverted residual block ×2 | 1 | ||

| 72×160 | Bottleneck | 1 | |

| 72×320 | Conv 1×1 | 1 | |

| 72×1 280 | Avgpool 7×7 | — | |

| 12×1 280 | Linear | — | |

2.3 迁移学习

迁移学习是将充分训练所得的网络权重转移到新的任务中,这些权重是具有共性的数据信息,可以在新的任务中进行共享。使用大型训练集(Imagenet数据集)训练出权重参数,冻结部分特征提取层,只训练1层或几层参数。选择迁移学习的方法进行驾驶人行为识别,加快模型推导速度,保留预训练模型所具有的识别能力。

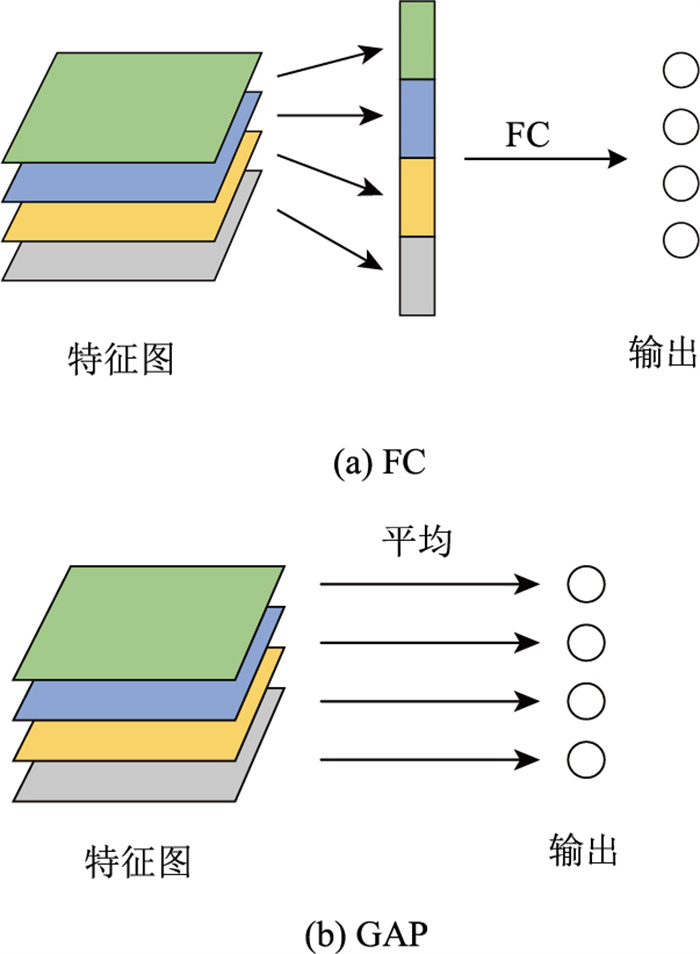

2.4 MobileNet-GX 2.4.1 全局平均池化全连接层(FC)与softmax逻辑回归连用,将卷积层学习到的分布式特征图映射到样本标记空间。全连接层参数多,容易过拟合,会降低模型泛化能力。全局平均池化(GAP)对特征图进行逐通道平均运算,输出的特征向量维度与样本标记类别相等,省略特征图的展平处理,不使用激活函数。FC与GAP处理流程对比见图 4。

|

| 图 4 FC与GAP对比 Fig. 4 FC v.s. GAP |

| |

2.4.2 GX模块

本研究提出了含有全局平均池化和残差的GX模块。首先,特征图经过一个含有3×3卷积的残差结构,残差分支使用批量归一化(Batch Nomalization,BN),整合瓶颈结构所输出的数据格式,使网络增加了一条梯度流动的路径;最大池化(Max Pooling)降低模型计算量和优化难度;两个1×1的卷积在不改变特征图大小的情况下,压缩特征图通道数,使特征图维度与驾驶人行为类别相同;最后的GAP层输出10个类别的驾驶人行为数据。GX模块实现了特征图的逐步降维,保留了对特征图的学习能力。在对MobileNet-V2结构优化中,仅保留连续的瓶颈结构,后接GX卷积模块,结构框架见图 5。

|

| 图 5 GX模块 Fig. 5 GX modules |

| |

2.4.3 训练策略

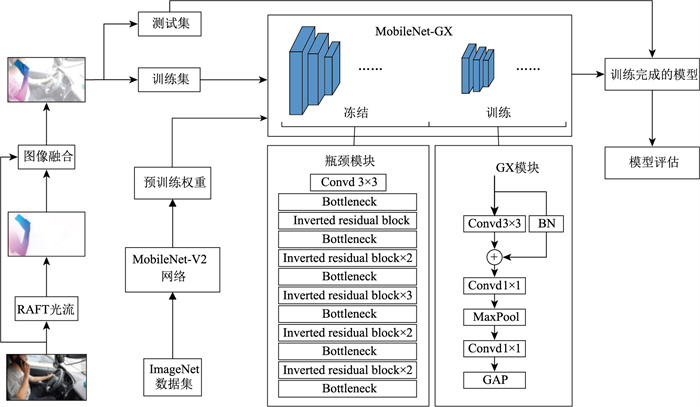

对驾驶人行为图像进行RAFT光流提取,原图像与光流图像融合后作为MobileNet-GX深度学习神经网络的输入。MobileNet-GX包含瓶颈模块和GX模块,迁移MobileNet-V2深度学习神经网络瓶颈模块的预训练权重并冻结,训练GX模块,得到MobileNet-GX的训练权重。训练策略见图 6。

|

| 图 6 训练策略 Fig. 6 Training strategy |

| |

3 试验验证 3.1 试验环境

本试验计算机环境见表 4。应用迁移学习的方法训练神经网络,使用交叉熵损失函数,优化器采用自适应矩估计,学习率为10-5,Batch size设置为16,迭代60个epoch。

| 类别 | 型号 |

| 系统 | Window10 |

| 内存 | 64 GB |

| 处理器 | Intel(R) i9-10900K CPU @ 3.70 GHz |

| GPU型号 | NVIDIA GeForce RTX 3090 |

| Python | Python3.8 |

| Pytorch | Pytorch 1.11.0 |

| CUDA | CUDA 11.3 |

3.2 评估指标

采用准确率(Ac) 和精确率(Pp)作为评估神经网络的指标。准确率表示预测正确的样本数量占总量的百分比,见式(7)。

| $ A_{\mathrm{c}}=\frac{T_{\mathrm{P}}+T_{\mathrm{N}}}{T_{\mathrm{P}}+T_{\mathrm{N}}+F_{\mathrm{P}}+F_{\mathrm{N}}} $ | (7) |

精确率表示正确预测为正类的样本占全部预测为正类样本的比例,见式(8)。

| $ P_{\mathrm{p}}=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{P}}}, $ | (8) |

式中,TP为真正类(实例为正,预测为正);TN为真负类(实例为负,预测为负);FP为假正类(实例为负,预测为正);FN为假负类(实例为正,预测为负)。

3.3 试验结果及分析选用适当数据集训练神经网络,可提升和优化模型的识别准确率和泛化性能,避免由于训练数据集导致的过拟合。

为验证数据集规模对试验结果的影响,以8 069张图像规模的数据集为基础(原始数据),通过删减和图像增强方法,提供5种规模的数据集(样本规模分别为7 069,7 569,8 069,8 569,9 069张,均按照9∶1划分出训练集和测试集)。需要注意的是,经过RAFT光流融合后,数据集规模由8 069张增加至8 569张和9 069张,准确率随着数据集规模的增加反而减小。因此,选用8 069张图像样本的数据集,对比分析测试集上6种深度学习神经网络的性能(见表 5)。本研究提出的MobileNet-GX在测试集上的准确率达到98.75%,优于VGG-16,GoogLeNet,ShuffleNet-V2,DenseNet-121,MobileNet-V2的准确率,模型整体表现较好。

| 网络模型 | 文件大小/KB | 光流融合 | 测试准确率/% | 测试速度v/(it·s―1) |

| VGG-16 | 524 627 | 是 | 56.66 | 43.04 |

| 否 | 52.92 | 40.27 | ||

| GoogLeNet | 40 418 | 是 | 98.13 | 57.50 |

| 否 | 94.89 | 52.62 | ||

| ShuffleNet-V2 | 5 106 | 是 | 50.06 | 55.86 |

| 否 | 47.19 | 52.41 | ||

| DenseNet-121 | 27 793 | 是 | 83.31 | 53.92 |

| 否 | 81.19 | 48.64 | ||

| MobileNet-V2 | 8 975 | 是 | 85.55 | 55.69 |

| 否 | 81.56 | 51.53 | ||

| MobileNet-GX | 11 816 | 是 | 98.75 | 57.33 |

| 否 | 97.01 | 53.04 |

采用MobileNet-GX深度学习神经网络,图像经RAFT光流融合后,减少了驾驶室背景噪声并突出驾驶人行为特征,准确率提高1.74%~3.99%,测试速度提高6.17%~9.78%。MobileNet-GX和MobileNet-V2训练过程中随着迭代次数的增加,训练损失和测试准确率逐渐收敛。MobileNet-GX初始性能不佳,但经过3次迭代后训练损失低于MobileNet-V2,收敛后准确率处于较高水平。

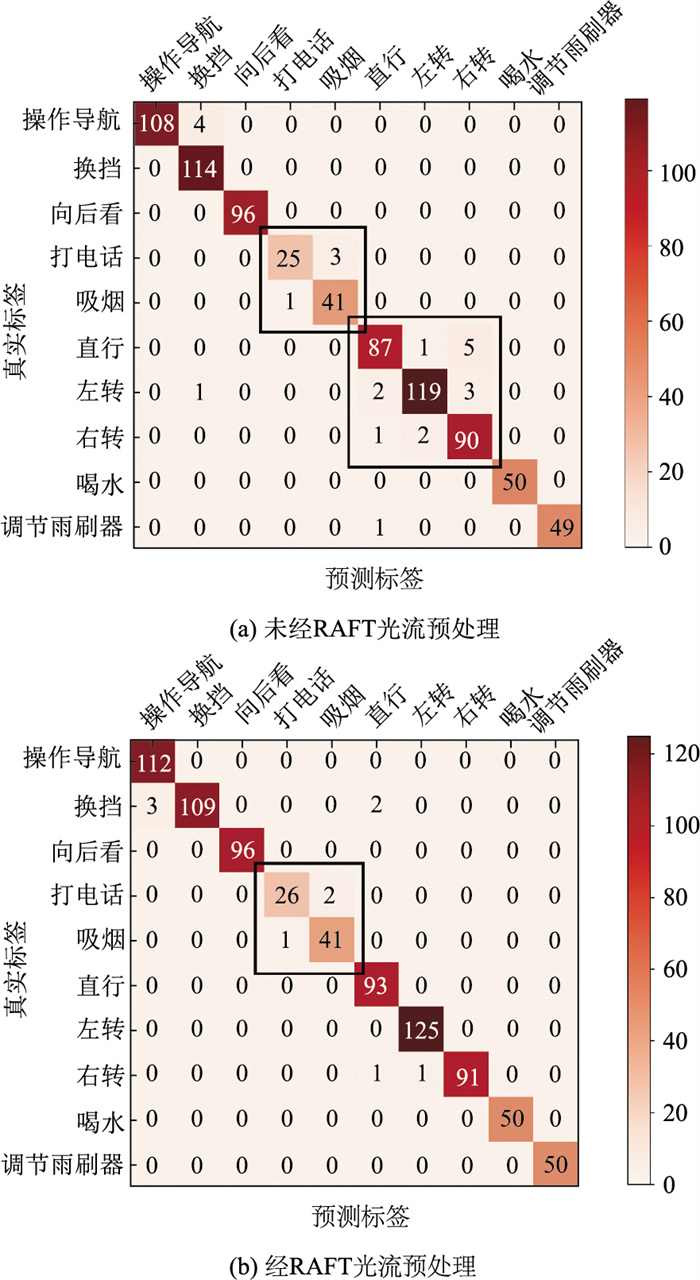

选择MobileNet-GX作为分类网络,经RAFT光流预处理前后混淆矩阵见图 7,对角线代表各类驾驶人行为识别正确数量,其余数值为识别错误类别数量。图中,驾驶人行为数据经RAFT光流预处理后,直行和左转两类行为无混淆情况,打电话和吸烟两类行为混淆数量下降。

|

| 图 7 RAFT光流预处理前后混淆矩阵对比 Fig. 7 Comparison of confusion matrix before and after RAFT optical flow pre-processing |

| |

驾驶人行为识别精确率见表 6。使用RAFT光流预处理后,操作导航、打电话、直行、左转、右转、调节雨刷器6类行为精确率得到提升。

| 预处理 | 操作导航 | 换挡 | 向后看 | 打电话 | |

| 原始图像/% | 96.4 | 100 | 100 | 89.3 | |

| Raft光流/% | 100 | 95.6 | 100 | 92.9 | |

| 吸烟 | 直行 | 左转 | 右转 | 喝水 | 调节雨刷器 |

| 97.6 | 93.5 | 95.2 | 96.8 | 100 | 98 |

| 97.6 | 100 | 100 | 97.8 | 100 | 100 |

4 结论

通过对驾驶人行为图像进行光流融合,提出了一种基于RAFT光流融合的驾驶人行为识别方法,降低了驾驶室背景噪音对驾驶人行为识别的影响。使用含有残差和GAP层的GX模块替代全连接层,提升了全连接层学习能力和计算速度,建立了MobileNet-GX驾驶人行为识别模型。自建Driver-seq数据集对模型进行优化训练,丰富了驾驶人行为公开数据集。通过试验对比,提出的驾驶人行为识别模型具有更高的准确率,权重文件相对较小,运行速度更快,更易嵌入车载摄像头,实现驾驶人行为的实时感知,对提升驾驶安全具有重要意义。

| [1] |

KATEŘINA B, EVA M, ROBERT Z, et al. Human factors contributing to the road traffic accident occurrence[J].

Transportation Research Procedia, 2020, 45(6): 555-561.

|

| [2] |

夏萧菡, 陆建, 马潇驰, 等. 异常驾驶行为数据驱动的高速公路实时事故风险预测[J]. 公路交通科技, 2024, 41(10): 1-7. XIA Xiaohan, LU jian, MA Xiaochi, et al. Real-time expressway crash risk prediction based on abnormal driving behavior[J]. Journal of Highway and Transportation Research and Development, 2024, 41(10): 1-7. DOI:10.3969/j.issn.1002-0268.2024.10.001 |

| [3] |

MOHAMMAD S, MAHMOOD F, REZA B, et al. Driver behavior detection and classification using deep convolutional neural networks[J/OL]. Expert Systems with Applications, 2020, 149: 113240.https://doi.org/10.1016/j.eswa.2020.113240.

|

| [4] |

FU R, WANG H, ZHAO W. Dynamic driver fatigue detection using hidden Markov model in real driving condition[J].

Expert Systems with Applications, 2016, 63(30): 397-411.

|

| [5] |

LI M, WANG W, LIU Z, et al. Driver behavior and intention recognition based on wavelet denoising and bayesian theory[J].

Sustainability, 2022, 14(11): 6901.

DOI:10.3390/su14116901 |

| [6] |

申天啸, 韩怡园, 韩冰, 等. 基于人类视觉皮层双通道模型的驾驶员眼动行为识别[J]. 智能系统学报, 2022, 17(1): 41-49. SHEN Tianxiao, HAN Yiyuan, HAN Bing, et al. Recognition of driver 's eye movement based on the human visual cortex two-stream model[J]. Journal of Intelligent Systems, 2022, 17(1): 41-49. |

| [7] |

王冠, 李振龙. 基于反向双目识别的驾驶员分心检测[J]. 科学技术与工程, 2018, 18(17): 82-88. WANG Guan, LI Zhenlong. Driver distraction detection based on reverse binocular recognition[J]. Science Technology and Engineering, 2018, 18(17): 82-88. |

| [8] |

何丽雯, 张锐驰. 基于深度学习的驾驶员分心行为识别[J]. 计算机与现代化, 2022(6): 67-74. HE Liwen, ZHANG Ruichi. Driver distraction behavior recognition based on deep learning[J]. Computer and Modernization, 2022(6): 67-74. |

| [9] |

XIAO W, LIU H, MA Z, et al. Attention-based deep neural network for driver behavior recognition[J].

Future Generation Computer Systems, 2022, 132: 152-161.

DOI:10.1016/j.future.2022.02.007 |

| [10] |

ZHAO L, YANG F, BU L, et al. Driver behavior detection via adaptive spatial attention mechanism[J].

Advanced Engineering Informatics, 2021, 48: 101280.

DOI:10.1016/j.aei.2021.101280 |

| [11] |

ZHAO Y Y, JIA H W, LUO H Y, et al. An abnormal driving behavior recognition algorithm based on the temporal convolutional network and soft thresholding[J].

International Journal of Intelligent Systems, 2022, 37(9): 6244-6260.

DOI:10.1002/int.22842 |

| [12] |

杜虓龙, 余华平. 基于改进Mobile Net-SSD网络的驾驶员分心行为检测[J]. 公路交通科技, 2022, 39(3): 160-166. DU Xiaolong, YU Huaping. Driver distraction behavior detection based on improved mobile net-SSD network[J]. Journal of Highway and Transportation Research and Development, 2022, 39(3): 160-166. DOI:10.3969/j.issn.1002-0268.2022.03.020 |

| [13] |

QIN B B, QIAN J B, XIN Y, et al. Distracted driver detection based on a CNN with decreasing filter size[J].

IEEE Transactions on Intelligent Transportation Systems, 2022, 23(7): 6922-6933.

DOI:10.1109/TITS.2021.3063521 |

| [14] |

ERAQI H M, ABOUELNAGA Y, SAAD M H, et al. Driver distraction identification with an ensemble of convolutional neural networks[J/OL]. Journal of Advanced Transportation, 2019, 2019(1): 4125865. https://doi.org/10.48550/arXiv.1901.09097.

|

| [15] |

XU H Z, XING Z H, GE Y S, et al. Driver behaviour recognition based on recursive all-pair field transform time series model[J].

IET Intelligent Transport Systems, 2024, 18(9): 1559-1573.

DOI:10.1049/itr2.12528 |

| [16] |

HAN Y M, ZHANG P, ZHUO T, et al. Going deeper with two-stream ConvNets for action recognition in video surveillance[J].

Pattern Recognition Letters, 2018, 107: 83-90.

DOI:10.1016/j.patrec.2017.08.015 |

| [17] |

HAN J, YANG Y H. L-Net: Lightweight and fast object detector-based ShuffleNetV2[J].

Journal of Real-Time Image Processing, 2021, 18(6): 2527-2538.

|

| [18] |

SINGH D, KUMAR V, KAUR M. Densely connected convolutional networks-based COVID-19 screening model[J].

Applied Intelligence, 2021, 51: 3044-3051.

|

| [19] |

陈子昂, 郭唐仪, 隋立岩, 等. 基于YOLOv5s优化模型的道路交通标志异常状态检测[J]. 公路交通科技, 2024, 41(10): 8-16. CHEN Ziang, GUO Tangyi, SUI Liyan, et al. Traffic sign abnormality detection based on improved YOLOv5s model[J]. Journal of Highway and Transportation Research and Development, 2024, 41(10): 8-16. DOI:10.3969/j.issn.1002-0268.2024.10.002 |

2025, Vol. 42

2025, Vol. 42

,

,